mongo数据量不是很大,插入数据变慢

场景情况:

统计一些数据,分别放入200+个库中

当每个库中的数据量10W以上的时候,有的数据库插入就会变慢

加了慢日志,了解了各个字段的说明,但是没有分析出慢的原因,哪位大佬帮看看

谢谢

代码:

for db_key, insert_data_content := range db_name_to_insert_data{

each_start := time.Now().UnixNano()

err := dbvisit.InsertDataList(map[string]interface{}{"content": insert_data_content, "dbname": db_key, "tablename": SERVER_TRAFFIC_FLOW_LOG_TB})

each_use := (time.Now().UnixNano()-each_start)/1e6

if each_use > 50{

slow_count += 1

adframe.AddMustLog("----Insert Server Ip DataList:", err, db_key, len(insert_data_content), "use time:",each_use, "(ms)")

}

插入数据用的自己的框架

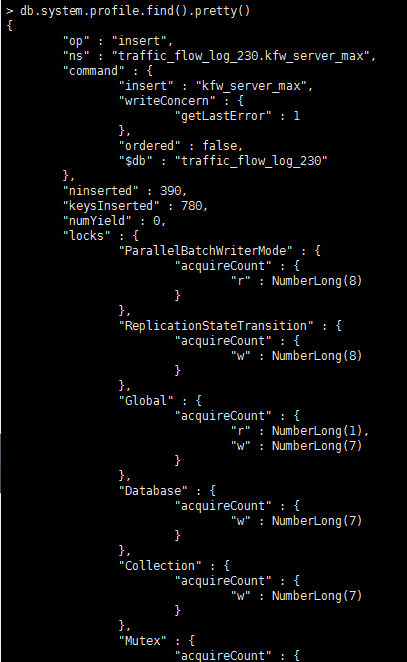

mongo慢日志如下:

https://blog.csdn.net/qq_40724463/article/details/92381684

是一条条插入还是批量插入,如果不是批量插入,改用批量插入试下