CUDA out of memory如何释放已分配的显存

跑一个简单的RL模型突然报这个:

RuntimeError: CUDA out of memory. Tried to allocate 17.00 MiB (GPU 0; 4.00 GiB total capacity; 2.90 GiB already allocated; 8.80 MiB free; 21.26 MiB cached)

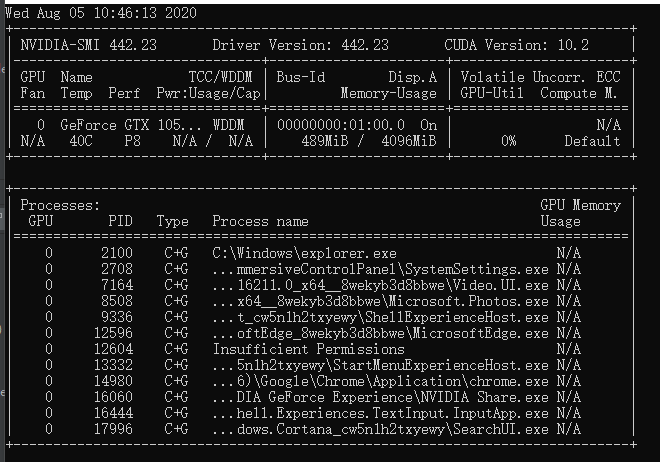

cmd中输入nvidia-smi发现多了好多进程,直接用kill杀死进程也无效

以前从来没有过这个问题,请问怎么才能释放着分配的2.90G,是不是因为我笔记本外接了一个显示器?

不知道你怎么一个使用的cuda,如果是tf/cudnn,这个得框架库去释放啊。你最好换工作站平台,用好一点地显卡/计算卡