关于maven打包jar包的问题

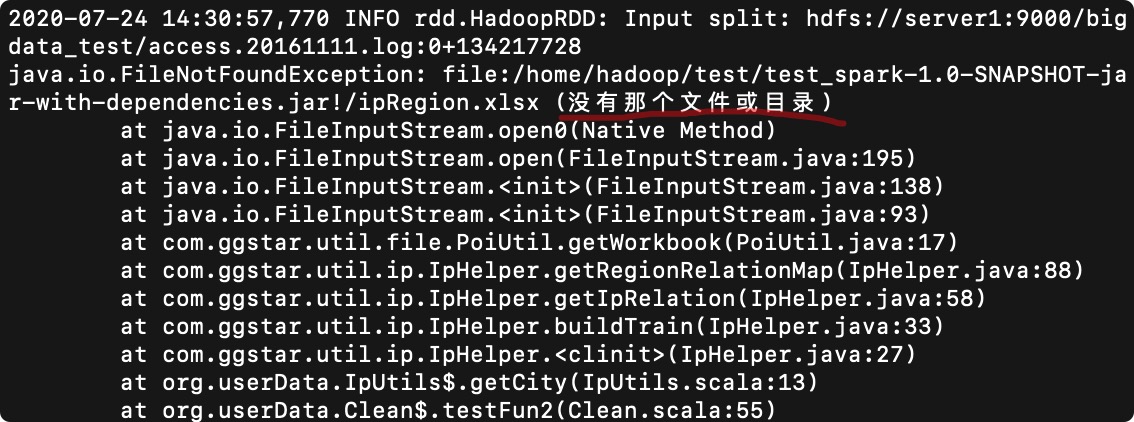

spark-submit --name testSpark --class org.userData.Clean --master local[2] --files /home/hadoop/test/ipRegion.xlsx /home/hadoop/test/test_spark-1.0-SNAPSHOT-jar-with-dependencies.jar

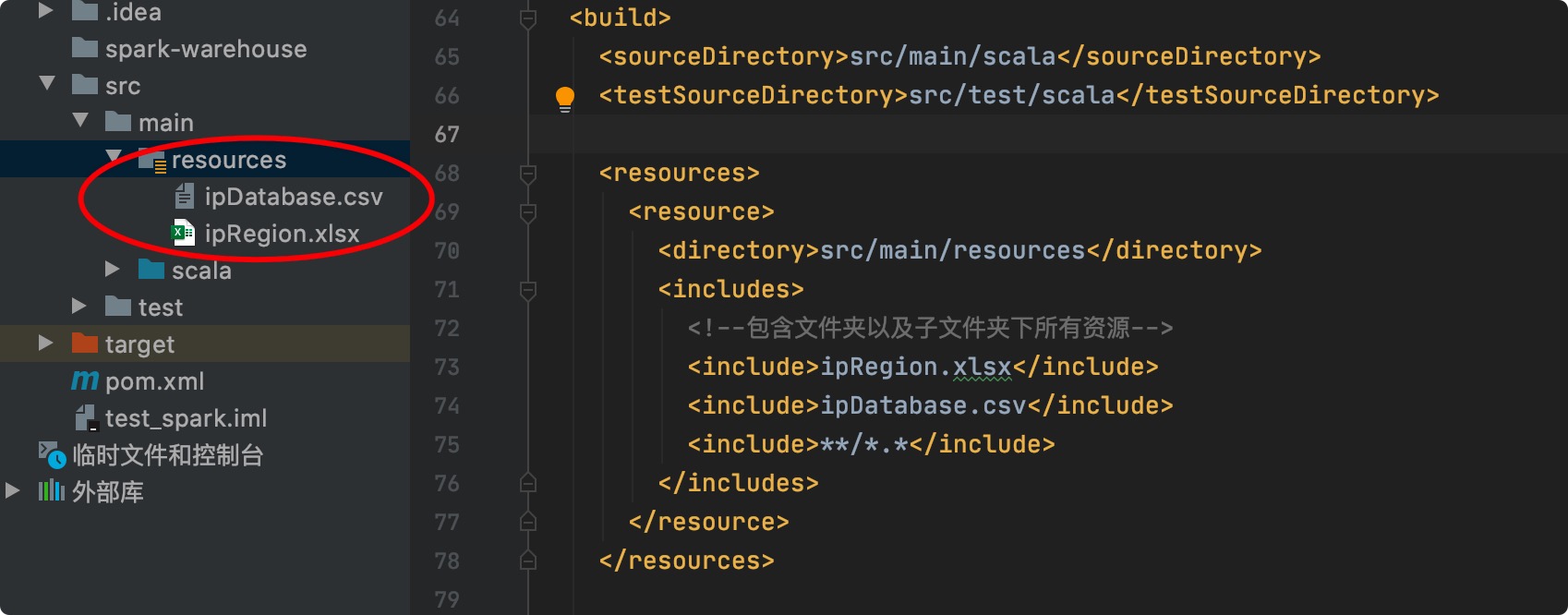

pom.xml里也设置过里,加了--files也试过,但就是没办法找到文件,请问要怎么解决?

我解压了一下jar包,发现文件的确是都在里面的,为什么还会提示找不到?

<resources>

<resource>

<!-- 设定主资源目录 -->

<directory>src/main/templates</directory>

<!-- maven default生命周期,process-resources阶段执行maven-resources-plugin插件的resources目标处理主资源目下的资源文件时,只处理如下配置中包含的资源类型 -->

<includes>

<include>**/*.xls</include>

<include>**/*.html</include>

<include>**/*.xlsx</include>

</includes>

<!-- maven default生命周期,process-resources阶段执行maven-resources-plugin插件的resources目标处理主资源目下的资源文件时,是否对主资源目录开启资源过滤 -->

<filtering>true</filtering>

</resource>

</resources>

照着配置一下

如果你是spring boot 的项目的话可以借鉴这个试试

在idea中 Maven构建的springboot项目打jar包

你的excel文件没有打包进去

参考这个打包 https://blog.csdn.net/cyberHerman/article/details/84031274

在 </includes 后面加这一句试试

<filtering>false</filtering>

或者可以rebuild一下试试。

你可以在前面加个${project.basedir}试试