spark on yarn 资源调度问题

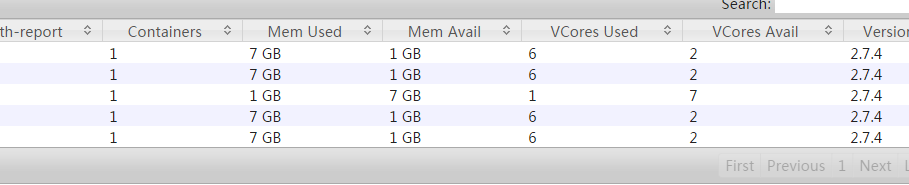

为什么spark在yarn上运行时,资源使用情况如下图:有一个结点的资源使用很少。

我的集群配置,一共六台电脑,一台运行驱动器,五台执行器,均为8g 8核,

spark启动如下:

pyspark --master yarn --num-executors 4 --executor-memory 6g --executor-cores 6 --conf spark.default.parallelism=50 --deploy-mode client

同时我设置--num-executors为4为什么会有5个contains,且不管--num-executors设置为多少,contaiers总是会+1

https://www.jianshu.com/p/9c540078d406

因为需要有一个conatiner去运行ApplicationMatesr,剩下的4个才是你指定的executor上运行任务的container,